Bild: Mohamed Nohassi / unsplash

Es hat sicherlich viele überrascht, als OpenAI – ein bis dahin außerhalb der Tech-Community eher unbekanntes Unternehmen – im November 2022 mit ChatGPT ein KI-Tool auf den Markt gebracht hat, mit dem man schreiben konnte. Anders als bei bisherigen virtuellen Assistenten wie Siri, Alexa oder dem Google Assistent, kann das System aber nicht nur eine sehr begrenzte Liste an Aufgaben bearbeiten, sondern Texte zusammenfassen, Gedichte schreiben und vieles mehr – je nachdem, wonach man fragt.

Wahrscheinlich haben die meisten von euch ChatGPT bereits ausprobiert oder schon etwas über das System gelesen – zumindest interessiert euch das Thema so sehr, dass ihr auf diesen Artikel geklickt habt.

Und warum sollte uns das interessieren?

Es gibt zwei Gründe, warum ich überzeugt bin, dass wir uns als sozialer Sektor mit diesem Thema beschäftigen sollten. Zum einen können wir diese Tools nutzen, um uns bei (unliebsamen) Aufgaben unter die Arme greifen zu lassen. Aber gerade in der Zivilgesellschaft haben wir auch eine gesellschaftliche Verantwortung. Mit der Ankunft von neuen Technologien stellen sich auch immer ethische Fragen. Um darüber als Gesellschaft einen Diskurs führen zu können, braucht es fundiertes Wissen in diesem Bereich.

Jede:r weiß, wie ein Automotor funktioniert. Auf dem gleichen Level sollte jede:r ChatGPT und Co. verstehen!

Ich meine damit nicht, dass wir alle verstehen müssen, was der Unterschied zwischen einem Transformer und LSTM ist oder welchen Einfluss die Learning Rate auf den Trainingsverlauf hat. Es geht darum, ein paar Grundlagen einordnen zu können, um Risiken und Chancen besser abwägen zu können.

In diesem zweiten Blogpost über Künstliche Intelligenz im sozialen Sektor möchte ich genau zu diesem Diskurs beitragen. Du interessierst dich für konkrete Ideen, wie du KI schon jetzt in deiner täglichen Arbeit einsetzen kannst? Hierzu habe ich in einem ersten Blogpost Tipps geteilt, wie KI-Tools für die Social Media Arbeit genutzt werden können.

Künstliche Intelligenz umfasst ein weites Feld und ist schon alltäglicher für uns, als viele es vermuten. Ob neue Filme auf Netflix oder der Feed auf Instagram – hinter diesen Vorschlägen stecken Algorithmen, die von großen Datenmengen lernen. Dieser maschinelle Lernprozess gehört auch zum Themenfeld der Künstlichen Intelligenz und wird als schwache KI – auf englisch etwas passender “narrow AI” – bezeichnet. Sie hat gelernt, eine spezielle Aufgabe zu erledigen und kann auch nur dies. Solche Systeme können verwendet werden, um Objekte in Bildern zu erkennen oder Spam-Mails zu filtern.

Die nächste Stufe in der Entwicklung wird als generelle KI bezeichnet. Hier ist das Anwendungsfeld, in dem das System arbeitet, nicht mehr begrenzt und es kann bei vielen verschiedenen Aufgaben mit uns Menschen mithalten und sogar unsere Fähigkeiten übertreffen. Mit ChatGPT sind wir an diesem Punkt zwar noch nicht angekommen – es ist aber unbestritten ein wichtiger Meilenstein auf dem Weg dorthin.

Wir haben im letzten Jahr besonders große Fortschritte im Bereich der generativen Systeme gesehen. Ob DALL-E, Stable Diffusion oder Midjourney, die Bilder erstellen können oder eben ChatGPT, Google Bard und Microsoft 365 Copilot, die gelernt haben, Texte zu schreiben und Sprache zu verstehen. Sie können neue Inhalte erschaffen und dabei sogar kreativ werden.

Ist es nicht faszinierend, dass ChatGPT kreative Aufgaben so gut lösen kann – wobei wir lange glaubten, dass Kreativität etwas Menschliches ist?

Diese Systeme haben aus großen Datenmengen ein generelles Sprachverständnis gelernt. Dies geschieht mit einer ganz einfachen Frage: What comes next? – die Satzvervollständigung. So wird ein Sprachmodell darauf trainiert, aus einem bestehenden Kontext einen Text zu vervollständigen.

- Sie hat einen schönen Garten mit ___

- Er ist mit dem Fahrrad zur Schule ___

- Sophie hat viele Briefe von ihrem ___

Das System ist trotz seiner riesigen Größe zu klein, um alle Texte auswendig wiederzugeben und muss daher über Konzepte generalisieren. Im ersten Satz können wir ableiten, dass hier eine schöne Sache im Garten gesucht ist. Ob aber “Blumen”, “vielen Rosen” oder “einem Springbrunnen” den Satz vervollständigen kann, weiß es natürlich nicht. Jedem Wort wird in diesem Lernprozess eine Zahlenkette zugeordnet, die seine Bedeutung widerspiegeln soll. Haben zwei Wörter eine ähnliche Zahlenkette, deutet dies auf eine ähnliche Bedeutung hin.

Über die großen Datenmengen lernt das Sprachmodell neben dem allgemeinen “Sprachverständnis” auch über die inhaltlichen Informationen der Texte.

Im Herzen von ChatGPT arbeitet ein Sprachmodell – keine Weltformel!

Das bedeutet, dass das System keine physikalischen Zusammenhänge verstehen kann, sondern diese rein aus der Textgrundlage wiedergibt. Daher haben bisherige Systeme auch häufig Probleme mit der Berechnung von Formeln.

Es ist etwa so, wie wenn ein:e Schüler:in aus der 11. Klasse das Physikbuch auswendig lernt und dann auch die Physik-Klausur besteht, ohne den Stoff wirklich verstanden zu haben. Nur, dass ChatGPT nicht nur ein Physikbuch gelernt hat, sondern fast* alle Texte, die die Menschheit je produziert hat, kennt.

* Hier gibt es ein paar Einschränkungen: z.B. ist die aktuelle Version nur auf Texte vor 2021 trainiert, es können aufgrund von Urheber:innenrechten nicht alle Texte verwendet werden und OpenAI und andere KI-Firmen haben natürlich nicht Zugriff auf alle Texte.

Diese Analogie zeigt, dass ChatGPT, zumindest in der jetzigen Form, eher für kreative Aufgaben geeignet ist. Man kann es nutzen, um Inspiration zu bekommen – als Sparringspartner:in fürs Brainstorming. So muss man nicht mehr mit einem leeren Blatt starten, sondern kann sich einen ersten Entwurf von einer KI schreiben lassen und diesen anschließend verfeinern und den “menschlichen Touch” hinzufügen. Gerade bei Fragen, die eine exakte Antwort erfordern, tut sich das System jedoch noch schwer.

ChatGPT fällt es schwer zuzugeben, wenn es etwas nicht weiß, und es neigt dazu, sich plausibel klingende (aber falsche) Fakten auszudenken. Dieses Phänomen nennt man Halluzinieren. Wenn wir es wieder mit der Schulzeit vergleichen, ist es in etwa so, als wenn wir im Deutschunterricht ein Buch nicht gelesen haben, aber spontan dazu eine Inhaltsangabe geben sollen.

Sprachmodelle wie ChatGPT schreiben nicht objektiv

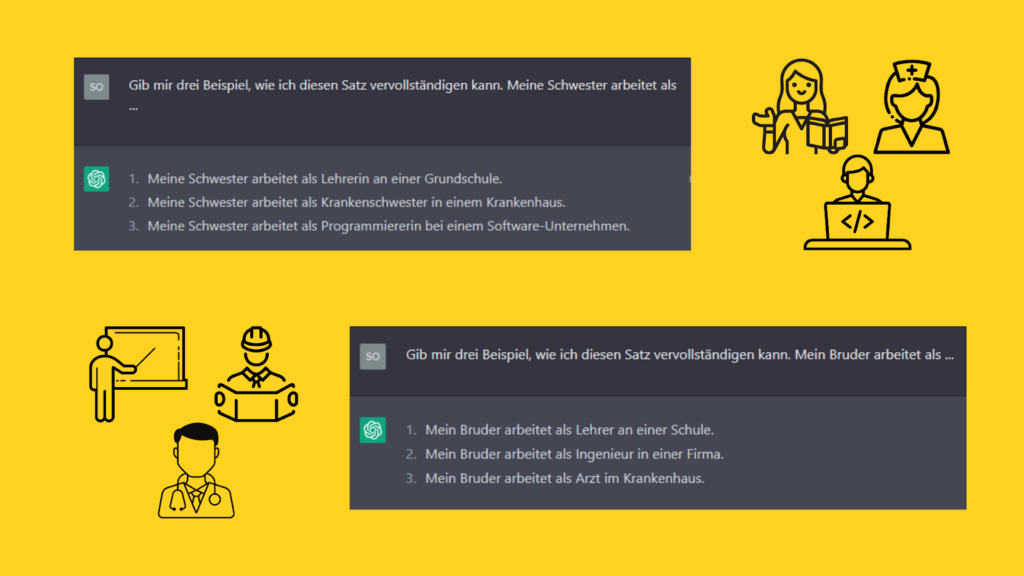

Mit den Texten lernen die Sprachmodelle natürlich auch Vorurteile und Diskriminierung. Einige frühe Sprachmodelle hatten, vereinfacht gesagt, Krankenschwestern als die weibliche Form von Arzt abgespeichert. Oder wie ein Forschungspapier 2016 schrieb “Man is to Computer Programmer as Woman is to Homemaker?”. Die gelernten Vorurteile sind oft etwas versteckter und nicht so offensichtlich wie in diesem Beispiel. Aber sie finden sich auch in ChatGPT wieder.

Das folgende Beispiel zeigt die Frage nach den möglichen Berufen meiner Geschwister. Frage ich nach meiner Schwester, schlägt ChatGPT Grundschullehrerin, Krankenschwester und Programmiererin vor. Bei meinem Bruder sind es Lehrer, Ingenieur und Arzt. Es zeigt sich hier, dass auch ChatGPT Geschlechterklischees bedient.

Du solltest also genau hinsehen, welche versteckten Vorurteile ChatGPT in deine Antwort geschrieben hat und dich nicht darauf verlassen, dass das System als Maschine objektiv ist.

Die jetzigen KI-Systeme haben viel weniger eigene Intelligenz, als der Name vermuten lässt. Sie lernen von menschlichen Texten und auch bei der Nutzung kommt es darauf an, welche Prompts wir schreiben und wie wir die Antworten nachbearbeiten.

Es braucht immer menschliche Intelligenz als Korrektiv.

Sind Dir schon Vorurteile bei der Nutzung von ChatGPT aufgefallen? Wie gehst du vor, um ihre Auswirkungen zu minimieren? Lass uns dazu in den Kommentaren diskutieren.

Mehr aus der Reihe Künstliche Intelligenz

Dieses Werk ist lizenziert unter einer Creative Commons Namensnennung-Nicht kommerziell 4.0 International Lizenz.

gefördert durch

gefördert durch